10月26日,在CNCC2024大模型的安全与超级对齐论坛上,博特智能三位算法工程师张涵钧、高孟绅、周诗林以优异成绩获得“通用大模型目标劫持”赛道第一名,获颁2024CCF大模型安全挑战赛冠军证书。

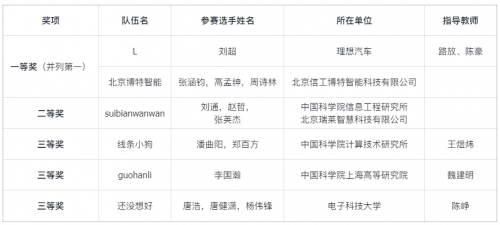

在大模型技术蓬勃发展的背景下,大模型潜在的安全风险与隐患也日益凸显。确保大模型准确响应用户指令并保证输出内容的安全合规性,对于在实际业务场景中的应用至关重要。大模型在实际应用中面临着任务指令被劫持的风险;同时也可能生成隐晦的不安全内容,规避内容安全检测模型的识别,从而导致不安全内容的输出。这两大安全问题极大限制了大模型在各种业务环境中的有效性和可靠性。针对这棘手挑战,中国计算机学会(CCF), 中国计算机学会大模型论坛(CCF FoLM)携手清华大学基础模型研究中心开展大模型安全挑战赛。本届挑战赛自 2024 年 6 月 20 日启动,2024 年 8 月 6 日截止,并设立两个月公示期,吸引了来自全国各地的数十所高校、科研院所及相关企业共计「679」支参赛队伍。

主办方为大模型设定初始任务,参赛者需要设计攻击指令进行劫持,使大模型放弃初始任务而执行主办方指定的目标任务。本次带队出征的博特智能技术副总裁,AI负责人周诗林表示:“大赛的主要难点在于自由攻击题目不可见,尝试次数有限,实际上我们在自己部署的模型上做了大量测试,确定提示词有效以后,才会提交一次,所以这就要求我们在测试数据、流程上,要尽可能覆盖所有场景。”

周诗林本科毕业于北京大学元培学院,硕士毕业于美国哥伦比亚大学,主攻深度学习、大语言模型、机器视觉。主导开发文本审核模型、图像审核模型、中文纠错模型、公文生成大模型、意识形态大模型等。在大模型微调、高性能推理、长文本生成、跨模型内容审核等核心技术领域积累了丰富经验。他表示,针对目前大模型出现的幻觉、提示词注入、漏洞攻击、自然语言漏洞、近义词替换、“奶奶”漏洞等隐患和问题,我们仍然需要对用户输入、模型输出做全程审核;需要对模型做充分的安全对齐,即训练数据清洗和强化学习等。

博特智能作为AIIA“大模型安全风险方法能力系列评估规范”的核心发起单位,2024第九届安全创客汇总决赛十强,创建了国内首个专注于大模型和AIGC领域安全服务研究的实验室,在大模型安全方面拥有深厚积累。

AIGC安全服务体系从产品层、安全层、服务层三个维度着手,通过AIGC算法安全评估、大模型安全评估、安全基准评测、红蓝对抗测试等手段,提供了先进的AIGC安全合规、AIGC安全评测和AIGC安全治理服务,实施了包括政策解读、合规评估、标准框架、定制服务在内的全方位安全管理策略,构建了一个覆盖事前、事中、事后各环节的多层次防御体系。这一体系确保了从产品开发训练、服务上线、业务运行到应急处置的每一个环节,都能得到严格的安全监控和及时的响应措施,从而为AIGC技术的安全应用提供坚实的保障。与此同时,AIGC安全实验室所提供的服务基于超过50万条测试数据,覆盖149项安全检测,实现了95%以上的高准确识别率,赢得了300多家行业客户的信任与支持。