英特尔推出的第四代和第五代英特尔® 至强® 可扩展处理器及其内置的英特尔® 高级矩阵扩展(Intel® Advanced Matrix Extensions,英特尔® AMX)可进一步提高 AI 功能。与第三代英特尔® 至强® 可扩展处理器相比,第五代英特尔® 至强® 可扩展处理器可使推理工作负载的性能提升高达 10 倍,每瓦性能提升高达 7 倍。

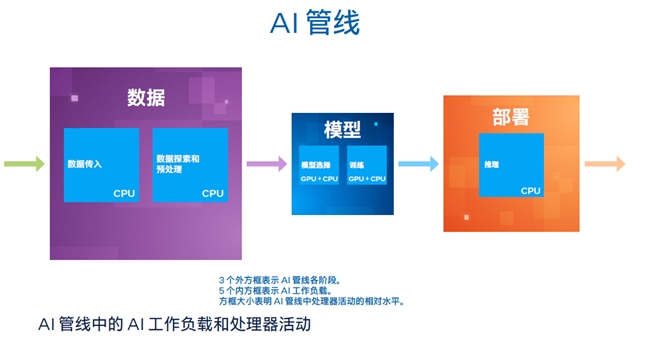

优化 AI 管线

从图书和电影推荐系统到驱动大型电商网站的数字化零售软件,再到支持聊天机器人和机器翻译的自然语言处理 (NLP) 功能,企业可通过在不同场景中应用 AI 获得诸多收益。 AI 真正的价值在于其能够解析复杂环境和海量数据的特性,以及解决以往难解之题的能力,而这正是不断推进企业革新的关键潜能。据研究显示,到 2025 年,90% 新发布的企业应用版本都将包含嵌入式 AI 功能。

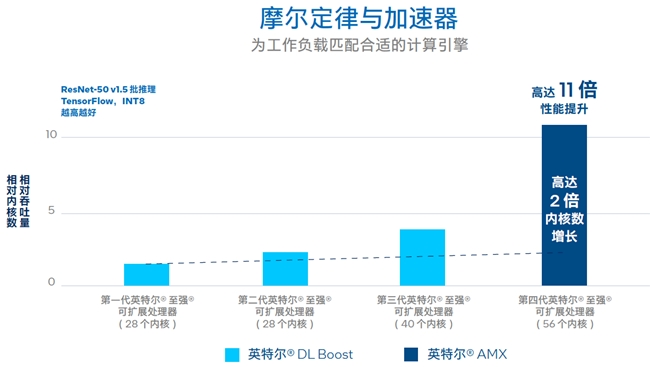

第四代和第五代英特尔® 至强® 可扩展处理器内置 AI 加速器——英特尔® AMX,是企业和机构优化 AI 管线的理想选择。平衡推理是 CPU 在 AI 应用中的主要用例,而这款英特尔® AI 引擎专为该用例设计并且具备更多训练能力(见图 )。目前,在所有运行 AI 推理工作负载的已装机数据中心处理单元中,英特尔® 至强® 可扩展处理器的占比高达 65%; 因此,为新的 AI 部署选择内置英特尔® AMX 的第四代和第五代英特尔® 至强® 可扩展处理器,是一种既高效又具有成本效益的 AI 工作负载加速方式。

选择内置加速器的理由

目前,采用内置英特尔® 深度学习加速技术(Intel® Deep Learning Boost,英特尔® DL Boost)的第三代英特尔® 至强® 可扩展处理器支持 AI 部署,可满足 IT 部门履行客户服务级别协议 (SLA) 的要求,而内置英特尔® AMX 的第四代和第五代英特尔® 至强® 可扩展处理器则将带来新的变革。

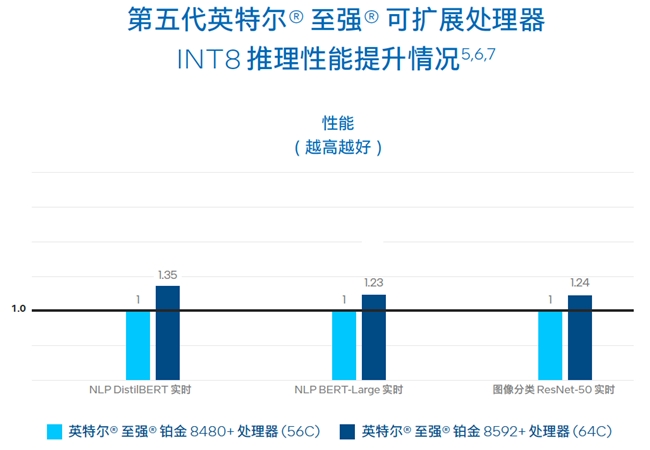

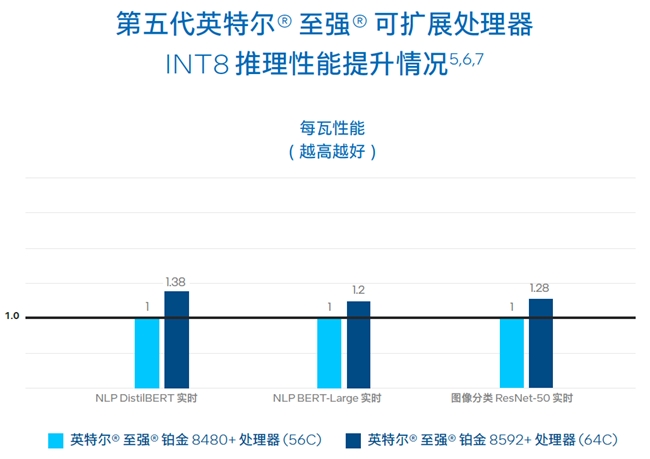

如图所示:与上一代产品相比,内置英特尔® AMX 的第五代英特尔® 至强® 可扩展处理器,可将实时推理性能提升高达 1.23 至 1.35 倍,可将实时推理每瓦性能提升高达 1.2 至 1.38 倍5,6,7。

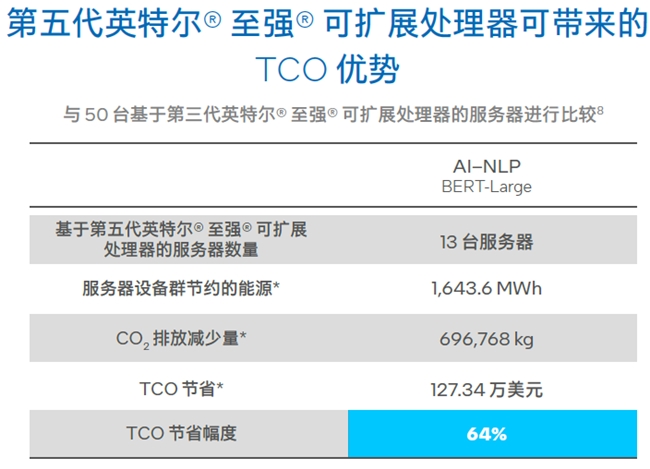

第五代英特尔® 至强® 可扩展处理器与第三代英特尔® 至强® 可扩展处理器相比能够带来的总体拥有成本 (TCO) 优势。针对批量 NLP 推理 (BERT-Large) 工作负载,只需 13 台基于第五代英特尔® 至强® 可扩展处理器的服务器即可实现 50 台基于第三代英特尔® 至强® 可扩展处理器的服务器所能提供的性能8。服务器数量的减少意味着更低的能耗和更低 CO2 排放量,从而实现多达 64% 的 TCO 节约8。

英特尔® AMX 带来的性能提升远大于每一代产品(从第一代英特尔® 至强® 可扩展处理器开始)通过增加内核所实现的性能提升。

欲了解更多行业应用详情,请访问硬蛋聚合商官网

「免责声明」:以上页面展示信息由第三方发布,目的在于传播更多信息,与本网站立场无关。我们不保证该信息(包括但不限于文字、数据及图表)全部或者部分内容的准确性、真实性、完整性、有效性、及时性、原创性等。相关信息并未经过本网站证实,不对您构成任何投资建议,据此操作,风险自担,以上网页呈现的图片均为自发上传,如发生图片侵权行为与我们无关,如有请直接微信联系g1002718958。